Cómo funcionan los motores de búsqueda: Rastreo, Indexación y Clasificación

Un motor de búsqueda es como un auto-contestador. Existen para descubrir, comprender y organizar el contenido de Internet con el fin de ofrecer los resultados más relevantes a las preguntas que hacen los usuarios.

Para aparecer en los resultados de búsqueda -SERPs-, tu contenido primero debe ser visible para los motores de búsqueda. Podría decirse que es la pieza más importante del conglomerado SEO: si no se puede encontrar tu sitio, no hay forma de que aparezca en las SERPs (página de resultados del motor de búsqueda o Search Engine Results Page).

¿Cómo funcionan los motores de búsqueda?

Los motores de búsqueda funcionan a través de tres parámetros principales:

- Rastreo: buscan contenido en Internet, revisando el código/contenido de cada URL que encuentran.

- Indexación: almacena y organiza el contenido encontrado durante el proceso de rastreo. Una vez que una página está en el índice, está en ejecución para mostrarse como resultado de las consultas relevantes.

- Clasificación: proporciona las piezas de contenido que mejor responderán a la consulta de un buscador, lo que significa que los resultados se ordenan de más relevante a menos relevante.

Rastreo de Webs

Este es el medio por el cual los motores de búsqueda pueden encontrar lo que se publica en la World Wide Web. Esencialmente, rastrear es copiar lo que hay en las páginas web y revisar repetidamente la multitud de páginas para ver si han sido cambiadas y hacer una copia de cualquier cambio encontrado.

Los programas que tienen la tarea de hacer esto se conocen como robots, crawlers, spiders o alguna variación usando la palabra «web», por ejemplo, web crawler...

Indexación de Datos

Una vez que una «araña» ha rastreado una página web, la copia que se hace se devuelve al motor de búsqueda y se almacena en un centro de datos. Los centros de datos son enormes instalaciones de servidores construidos especialmente para esa función, que actúan como repositorio de todas las copias de las páginas web que realizan los rastreadores. Google posee docenas de estas construcciones en todo el mundo, que vigila muy de cerca y que se encuentran entre los edificios de más alta tecnología del mundo.

El repositorio de páginas web se conoce como el «índice», y es este almacén de datos el que se organiza y utiliza para proporcionar los resultados de búsqueda que los usuarios ven en el motor de búsqueda. La indexación es el proceso de organizar las ingentes cantidades de datos y páginas para que se puedan buscar rápidamente resultados relevantes en cada consulta de búsqueda.

El Algoritmo

Por último, tenemos una enorme colección de copias de páginas web que están siendo constantemente actualizadas y organizadas para que podamos encontrar rápidamente lo que estamos buscando. Pero necesitamos un medio por el cual se puedan clasificar por orden de relevancia para un término de búsqueda concreto. y es aquí donde entra en juego el Algoritmo.

El algoritmo es una ecuación muy compleja y de enorme longitud que calcula un valor para un sitio determinado en relación con un término de búsqueda. No sabemos cuál es el algoritmo en realidad, porque los motores de búsqueda tienden a mantener esto en secreto, muy bien guardado, de los competidores y de las personas que buscan modificar el motor de búsqueda para llegar a los primeros puestos. Dicho esto, se ha trabajado lo suficiente sobre el algoritmo para permitir que los expertos SEO aconsejen a los propietarios de sitios web sobre cómo mejorar sus páginas y los factores SEO para ascender en los rankings.

Vamos a desglosar cada uno de los apartados de forma amplia, con el fin de comprender cómo funcionan los motores de búsqueda.

Rastreo

El rastreo es el proceso de exploración en el que los motores de búsqueda envían un equipo de robots (conocidos como rastreadores -crawlers- o arañas -spiders-) para encontrar contenido nuevo y actualizado. Este contenido puede variar, puede ser una página web, una imagen, un video, un PDF, etcétera, pero independientemente del formato, el contenido se descubre mediante enlaces.

Créditos de la imagen: depositphotos.com

Créditos de la imagen: depositphotos.com

El robot de Google comienza buscando algunas páginas web y luego sigue los enlaces en dichas páginas para encontrar nuevas URLs. Al saltar a lo largo de esta ruta de enlaces, el rastreador puede encontrar contenido nuevo y agregarlo a su índice llamado Caffeine, una base de datos masiva de URLs descubiertas, que luego se recuperará cuando un motor esté buscando información y considere que el contenido es adecuado para ser listado.

¿Qué es el índice de los motores de búsqueda?

Los motores de búsqueda procesan y almacenan la información que encuentran en un índice, una enorme base de datos de todo el contenido que han descubierto y consideran lo suficientemente bueno para que los buscadores los ofrezcan a los usuarios.

Ránking de los motores de búsqueda

Cuando un usuario realiza una búsqueda, los motores recorren su índice en busca de contenido altamente relevante y luego ordenan ese contenido con la esperanza de resolver la consulta del buscador. Este orden de los resultados por relevancia se conoce como clasificación. En general, puede suponer que cuanto más alto se clasifica un sitio web, más relevante cree el motor de búsqueda que es el sitio para la consulta.

Es posible bloquear los rastreadores de los motores de búsqueda en parte del sitio o completamente, o indicar a estos que eviten almacenar determinadas páginas en su índice. Si bien puede haber razones para hacer esto, si deseas que los buscadores encuentren tu contenido, primero debes asegurarte de que sea accesible para los rastreadores y que sea indexable. De lo contrario, es casi invisible. Cuando nos referimos a «invisible» lo hacemos en todo el significado de la palabra, pues solo tú sabes que existe tu página, nadie mas.

¿Pueden los motores de búsqueda encontrar tus páginas?

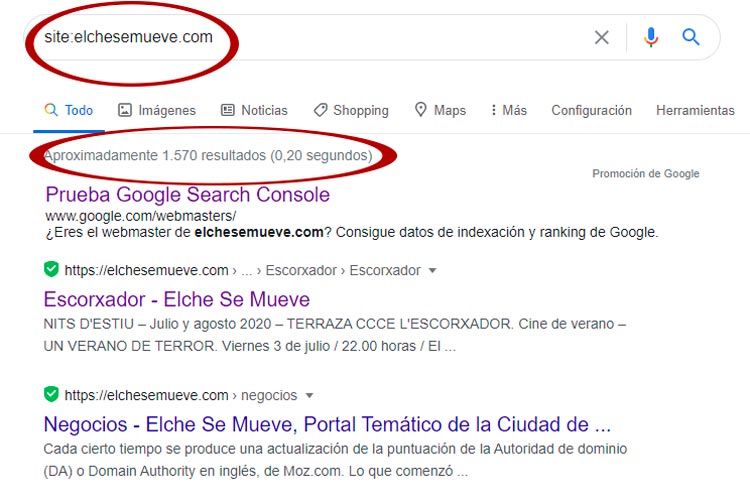

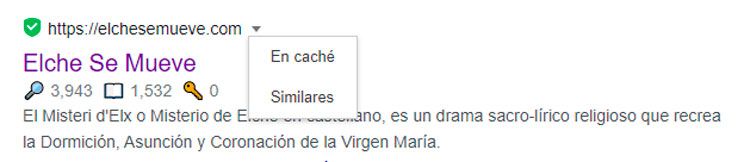

Como acabamos de ver, asegurarse de que tu sitio sea rastreado e indexado es un requisito previo para aparecer en las SERPs. Si ya tienes un sitio web, puede ser una buena idea comenzar viendo cuántas de tus páginas hay en el índice. Esto proporcionará una gran información sobre si Google está rastreando y encontrando todas las páginas que desea, y por supuesto las que no.

Una forma de comprobar tus páginas indexadas es escribiendo en la franja de las URLs del navegador "site: tudominio.com", tal cual, ya que se trata de un operador de búsqueda avanzada. Esto devolverá los resultados que Google tiene en su índice para el sitio especificado:

El número de resultados que muestra Google no es exacto, pero le da una idea sólida de qué páginas están indexadas de tu sitio y cómo se muestran actualmente en los resultados de búsqueda. De hecho, si vemos la consulta para Elche Se Mueve, el primer resultado que aparece está totalmente desactualizado, pues es de 2020 y el segundo, referente a "negocios", tiene una introducción sobre la autoridad de dominio. Es decir, solo has de tener en cuenta con esta consulta que estás en Google, nada más.

Para obtener resultados más precisos, supervise y utilice el informe de cobertura del índice en Google Search Console. Puede registrarse para obtener una cuenta gratuita de Google Search Console si actualmente no tienes una. Con esta herramienta, puedes enviar mapas de sitio para su sitio y controlar cuántas páginas enviadas se han agregado realmente al índice de Google, entre otras muchas cosas.

Si no apareces en ningún lugar de los resultados de la búsqueda, existen algunas razones, que podrían ser:

- Tu sitio es nuevo y aún no se ha rastreado.

- Tu sitio no está vinculado a ningún sitio web externo.

- La navegación de tu sitio hace que sea difícil para un robot rastrearlo de manera efectiva.

- Tu sitio contiene un código básico con directivas que bloquean los motores de búsqueda.

- Google ha penalizado tu sitio por tácticas de spam.

Indique a los motores de búsqueda cómo rastrear su sitio

Si usaste Google Search Console o el operador de búsqueda avanzada "site: tudominio.com" y descubriste que algunas de tus páginas importantes faltan en el índice y/o algunas de tus páginas menos importantes se han indexado por error, hay algunas optimizaciones que puedes implementar para orientar mejor al robot de Google cómo deseas que se rastree tu contenido web. Decirle a los motores de búsqueda cómo rastrear tu sitio puede proporcionarte un mejor control de lo que acaba entrando en el índice.

La mayoría de los usuarios piensa primero en asegurarse de que Google pueda encontrar sus páginas importantes, pero es fácil olvidar que es probable que haya páginas que no desean que Googlebot encuentre. Estos pueden incluir aspectos como URLs antiguas que tienen contenido poco relevante, URLs duplicadas (como parámetros de clasificación y filtrado para comercio electrónico), páginas de códigos de promoción especiales, páginas de prueba o de ensayo, etcétera.

Para desviar al robot de Google de determinadas páginas y secciones de tu sitio, utiliza robots.txt.

Robots.txt

Los archivos robots.txt se encuentran en el directorio raíz de los sitios web (por ejemplo, tudominio.com/robots.txt) y sugieren qué partes de tu sitio deben y no deben rastrear los motores de búsqueda, así como la velocidad a la que rastrean tu sitio, todo esto bajo el control de las directivas de robots.txt específicas. Este apartado lo trataremos en un artículo independiente -aún por escribir-.

El tratamiento que hace un motor de búsqueda de nuestro fichero robots.txt es el siguiente:

- Si el robot de Google no puede encontrar un archivo robots.txt para un sitio, procede a rastrear el sitio. Sí, no es imprescindible que exista el archivo robots.txt, pero tenerlo facilita las cosas a los rastreadores.

- Si el robot de Google encuentra un archivo robots.txt para un sitio, normalmente seguirá las sugerencias y procederá a rastrear el sitio. Como se ha visto antes, disponer de este archivo hace que los rastreadores no entren en un sitio como un elefante en una cacharrería.

- Si el robot de Google encuentra un error al intentar acceder al archivo robots.txt de un sitio y no puede determinar si existe o no, no rastreará el sitio. Por eso es muy importante que, si tienes el archivo en tu servidor, esté muy bien configurado.

No todos los rastreadores web siguen las directrices del archivo robots.txt. Los usuarios con malas intenciones (por ejemplo, raspadores -scraping- de direcciones de correo electrónico) crean bots que no siguen este protocolo. De hecho, algunos ciberdelincuentes utilizan archivos robots.txt para encontrar dónde has ubicado tu contenido privado. Aunque puede parecer lógico bloquear a los rastreadores y que no accedan a las páginas privadas, como las de inicio de sesión y de administración, con el fin de que no aparezcan en el índice, colocar la ubicación de esas URL en un archivo robots.txt de acceso público también significa que las personas con malas intenciones puede encontrarlos más fácilmente. Es mejor el atributo NoIndex para estas páginas y guardarlas detrás de un formulario de inicio de sesión en lugar de colocarlas en tu archivo robots.txt.

¿Puede un rastreador encontrar todo mi contenido relevante?

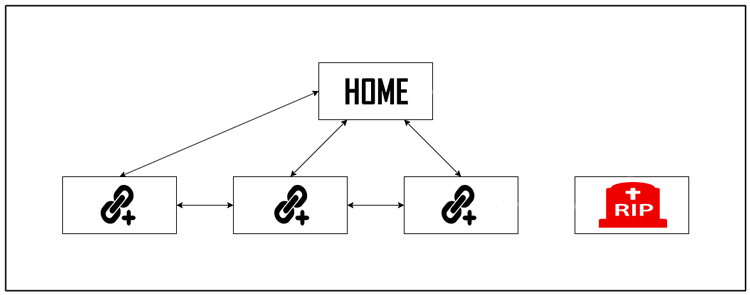

A veces, un motor de búsqueda podrá encontrar partes de tu sitio rastreando, pero otras páginas o secciones pueden quedar ocultas por una razón u otra. Es importante asegurarse de que los motores de búsqueda puedan descubrir todo el contenido que deseas indexar, y no solo tu página de inicio. En realidad se reduce a: ¿Puede el rastreador entrar por todo mi sitio web o solo a la Home?

Si requieres que los usuarios inicien sesión, por ejemplo, completen formularios o respondan encuestas antes de acceder a cierto contenido, los motores de búsqueda no verán esas páginas protegidas. Un rastreador no va a iniciar sesión, nunca.

Lo mismo ocurre con los formularios de búsqueda. Los robots no pueden utilizarlos. Algunos usuarios creen que si colocan un cuadro de búsqueda en su sitio, los motores podrán encontrar todo lo que buscan sus visitantes. Error.

Los formularios de contenido que no son de texto (imágenes, video, GIFs, etcétera) no deben usarse para mostrar el texto que deseas indexar. Si bien los motores de búsqueda están mejorando en el reconocimiento de imágenes, no hay garantía de que puedan leerlas y comprenderlas por el momento. Siempre es mejor agregar texto dentro del marcado «HTML» de tu página web.

¿Y la navegación del sitio?

Así como un rastreador necesita descubrir tu sitio a través de enlaces de otros sitios, necesita una ruta de links en tu propia web para guiarlo de una página a otra. Si tienes una página que desea que los motores de búsqueda encuentren pero no está vinculada desde ninguna otra, es casi invisible. Muchos sitios cometen el error crítico de estructurar su navegación de manera inaccesible para los motores de búsqueda, lo que dificulta su capacidad para aparecer en las SERPs.

Qué errores de navegación son los más comunes

- Tener una navegación móvil que muestre resultados diferentes a los de la de escritorio

- Cualquier tipo de navegación donde los elementos del menú no están en el código HTML, como las navegaciones habilitadas para JavaScript. Google ha mejorado mucho en el rastreo y la comprensión de Javascript, pero aún no es un proceso perfecto. La forma más segura de asegurarse de que Google encuentre, comprenda e indexe algo es escribiéndolo en HTML.

- La personalización, o mostrar una navegación única a un tipo específico de visitantes frente a otros, podría parecer un encubrimiento para un rastreador de motor de búsqueda.

- Olvidar el enlace a una página principal de tu sitio web a través de su navegación; recuerda, los enlaces son las rutas que siguen los rastreadores para acceder a nuevas páginas.

Por eso es esencial que su sitio web tenga una navegación clara y estructuras de carpetas URL útiles.

¿Tienes una arquitectura de la información limpia?

La arquitectura de la información es la práctica de organizar y etiquetar el contenido de un sitio web para mejorar la eficiencia y la capacidad de búsqueda de los usuarios. La mejor arquitectura de información es intuitiva, lo que significa que los usuarios no deberían tener que pensar mucho para navegar a través de tu sitio web o para encontrar la información que buscan.

¿Utilizas sitemaps -mapas del sitio-?

Un mapa del sitio es exactamente lo que dice su nombre: una lista de URLs en tu sitio que los rastreadores pueden usar para descubrir e indexar tu contenido. Una de las formas más fáciles de asegurarse de que Google encuentre tus páginas y que sepa cuáles son las prioritarias es crear un archivo que cumpla con los estándares de Google y enviarlo a través de Google Search Console. Si bien enviar un mapa del sitio no reemplaza la necesidad de una buena navegación del sitio, ciertamente puede ayudar a los rastreadores a seguir una guía hacia todas tus páginas importantes.

Errores de los rastreadores al acceder a tu sitio

En el proceso de rastreo de las URLs de tu sitio, un rastreador puede encontrar errores. Puedes ir al informe "Errores de rastreo" de Google Search Console para detectar las URLs en las que esto podría estar sucediendo; este informe te mostrará qué tipo de errores hay -encontrados- y los no encontrados. Los archivos de registro del servidor también pueden mostrarte esto, así como una información muy relevante, que es la frecuencia de rastreo, pero hay que tener en cuenta que que acceder y analizar los archivos de registro del servidor es una táctica más avanzada, por lo tanto no lo vamos a tratar ahora.

Antes de que pueda hacer algo significativo con el informe de errores de rastreo, es importante comprender los errores del servidor y los «no encontrados».

- Códigos 4XX: Los errores 4xx son errores del cliente, lo que significa que la URL solicitada contiene una sintaxis incorrecta o no se puede cumplir. Uno de los errores 4xx más comunes es el error «404 - no encontrado». Estos ocurren, en la mayoría de casos, debido a un error tipográfico de la URL, una página eliminada o un redireccionamiento roto, solo por nombrar algunos ejemplos. Cuando los motores de búsqueda alcanzan un 404, no pueden acceder a la URL. Cuando los usuarios llegan a un 404, suelen frustrarse y marcharse. En el 100% de los casos.

- Códigos 5XX: Los errores 5xx son errores del servidor, lo que significa que donde se encuentra la página web no cumplió con la solicitud del buscador o del motor de búsqueda para acceder a la página. En el informe «Error de rastreo» de Google Search Console, hay una pestaña dedicada a estos errores. Por lo general, esto ocurre porque se agotó el tiempo de espera de la solicitud de la URL, por lo que Googlebot abandonó la solicitud. Afortunadamente, hay una manera de decirles tanto a los buscadores como a los motores de búsqueda que tu página se ha movido: el redireccionamiento 301 (permanente).

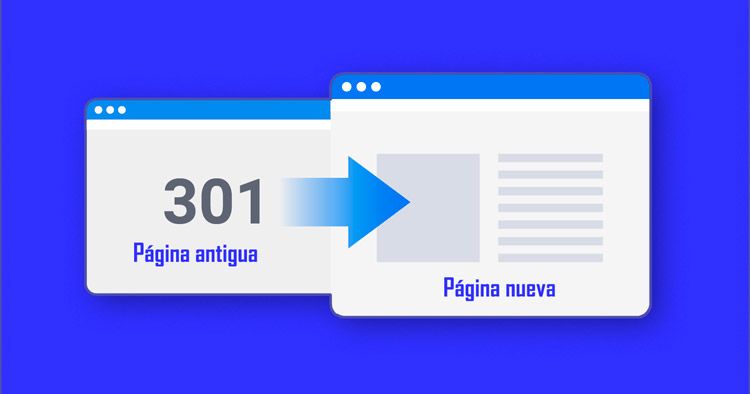

Si por la razón que sea, mueve una página de «tudominio.com/servicios/ a tudominio.com/services/» es necesario habilitar una pasarela para que los motores de búsqueda y los usuarios puedan encontrar la información antigua. Esa pasarela es una redirección 301.

- Cuando implementas una redirección 301, la autoridad de la página antigua se transfiere a la nueva. Sin ella, no se transfiere.

- En cuanto a la indexación, ayuda a los motores de búsqueda a encontrar la información en su nueva ubicación. Si por el contrario, el rastreador encuentra una página 404, que no es dañina por sí misma, hace que la clasificación decaiga.

- Una redirección 301 hace que los usuarios encuentren lo que buscan, mejorando la experiencia de los mismos -UX-. Por el contrario, si estos usuarios pinchan y se encuentran con una página 404, se desata la ira de los dioses.

El código 301 en sí mismo significa que la página se ha movido permanentemente a una nueva ubicación, así que evita redirigir las URLs a páginas irrelevantes, es decir, links donde el contenido de la URL anterior en realidad no se encuentra. Si una página está clasificada para una consulta y la redirección 301 a una URL con contenido diferente, podría bajar de posición porque el origen que la hizo relevante para esa consulta en particular ya no está allí. Los códigos 301 son potentes: mueve las URL de forma responsable.

También tienes la opción de redirección 302 de una página, pero esto debe reservarse para movimientos temporales y en los casos en que pasar la equidad del enlace no sea una gran preocupación. Los 302 son como un desvío de la carretera. Estás desviando tráfico temporalmente a través de una ruta determinada, pero no será así para siempre.

Indexación

Una vez que te hayas asegurado de que tu sitio ha sido rastreado, el siguiente paso es asegurarse de que se pueda indexar. El hecho de que un motor de búsqueda pueda descubrir y rastrear su sitio no significa necesariamente que se almacenará en su índice. En la sección anterior sobre rastreo, analizamos cómo los motores de búsqueda descubren las páginas web. El índice es donde se almacenan las páginas descubiertas. Una vez que un rastreador encuentra una página, el motor de búsqueda la representa como lo haría un navegador. En el proceso de hacerlo, el motor analiza el contenido de dicha página. Toda esa información se almacena en su índice. Este es el resumen fácil.

Indexación Motores de Búsqueda - Créditos de la imagen: depositphotos.com

Indexación Motores de Búsqueda - Créditos de la imagen: depositphotos.com

¿Se puede ver cómo un rastreador ve mis páginas?

Sí, la versión en caché de tu página reflejará una instantánea de la última vez que Googlebot la rastreó.

Google rastrea y almacena en caché las páginas web en diferentes frecuencias. Los sitios más establecidos y conocidos que publican con frecuencia, como https://marca.com, se rastrearán con más frecuencia que los portales con menos contenido actualizado o fresco.

Puede ver cómo se ve su versión en caché de una página haciendo clic en la flecha desplegable junto a la URL en las SERPs y eligiendo "En caché":

También puedes ver la versión de solo texto de tu sitio para determinar si tu contenido importante se rastrea y almacena en caché de manera efectiva.

¿Y se eliminan alguna vez del índice?

Sí, las páginas se pueden eliminar del índice. Algunas de las razones principales por las que se puede eliminar una URL incluyen:

- La URL muestra un error "no encontrado" (4XX) o un error del servidor (5XX). Esto podría ser accidental (la página se movió y no se configuró una redirección 301) o intencional (la página se eliminó y la versión 404 se modificó para eliminarlo del índice)

- La URL tenía una metaetiqueta noindex agregada: los propietarios del sitio pueden agregar esta etiqueta para indicar al motor de búsqueda que omita la página de su índice.

- La URL ha sido penalizada manualmente por infringir las Directrices para webmasters del motor de búsqueda y, como resultado, se eliminó del índice.

- Se ha bloqueado el rastreo de la URL con la adición de una contraseña requerida antes de que los visitantes puedan acceder a la página.

Si crees que una página de tu sitio web que anteriormente estaba en el índice de Google ya no aparece, puede utilizar la herramienta de inspección de URL para conocer el estado de la página o utilizar Explorar como Google, que tiene una función "Solicitar indexación" para enviar URL individuales al índice. (Bonificación: la herramienta "buscar" de Google Search Console también tiene una opción de "procesamiento" que le permite ver si hay algún problema con la forma en que Google está interpretando tu página).

Cómo indicar a los buscadores la forma de indexar mi sitio

Metadirectivas de robots

Las metadirectivas son instrucciones que puedes dar a los motores de búsqueda sobre cómo deseas que se trate tu página web.

Puedes decirle a los rastreadores instrucciones como "no indexar esta página en los resultados de búsqueda" o "no pasar ningún valor de enlace a ningún enlace en la página" Estas instrucciones se ejecutan a través de Robots Meta Tags en el «head» de tus páginas HTML (las más utilizadas) o mediante X-Robots-Tag en el encabezado HTTP.

Metaetiqueta de robots

La metaetiqueta robots se puede utilizar dentro del «head» del HTML de tu página web. Puedes excluir todos los motores de búsqueda o algunos de ellos. Las siguientes son las metadirectivas más comunes, junto con las situaciones en las que puede aplicarlas.

index/noindex les dice a los motores si la página debe ser rastreada y guardada en un índice de para su recuperación. Si optas por utilizar "noindex", estás comunicando a los rastreadores que deseas que la página se excluya de los resultados de búsqueda. De forma predeterminada, los motores de búsqueda asumen que pueden indexar todas las páginas, por lo que no es necesario utilizar el valor "índice".

- Cuándo se puede usar: Puedes optar por marcar una página como "noindex" si está tratando de recortar páginas con poco contenido del índice de Google de su sitio (por ejemplo, páginas de perfil generadas por el usuario) pero aún desea que sean accesibles para los visitantes.

follow/nofollow indica a los motores de búsqueda si los enlaces de la página deben seguirse o no. "Follow" da como resultado que los bots sigan los enlaces de tu página y pasen la equidad del enlace a esas URLs. O, si optas por emplear "nofollow", los motores de búsqueda no seguirán ni transferirán ningún valor de autoridad a los enlaces de la página. De forma predeterminada, se supone que todas las páginas tienen el atributo "follow".

- Cuándo se puede usar: nofollow se usa a menudo junto con noindex cuando está tratando de evitar que una página sea indexada, así como también de evitar que el rastreador siga los enlaces en la página.

noarchive se utiliza para impedir que los motores de búsqueda guarden una copia en caché de la página. De forma predeterminada, los motores mantendrán copias visibles de todas las páginas que han indexado, accesibles para los buscadores a través del enlace almacenado en caché en los resultados de búsqueda. En la anterior captura de pantalla tienes un ejemplo.

- Cuándo se puede usar: si tienes un sitio eCommerce y tus precios cambian con regularidad, podrías considerar la etiqueta noarchive para evitar que los usuarios vean precios desactualizados. Veamos un ejemplo:

<! DOCTYPE html> <html> <head> <meta name = "robots" content = "noindex, nofollow" /> </head> <body> ... </body> </html>

Este ejemplo excluye a todos los motores de búsqueda para indexar la página y de seguir cualquier enlace en la misma. Si deseas excluir varios rastreadores, como googlebot y bing, por ejemplo, está bien utilizar varias etiquetas de exclusión de robots.

Etiquetas X-Rotobs

La etiqueta x-robots se usa dentro del encabezado HTTP de tu URL, lo que brinda más flexibilidad y funcionalidad que las metaetiquetas si deseas bloquear los motores de búsqueda a escala porque puede usar expresiones regulares, bloquear archivos que no sean HTML y aplicar etiquetas noindex en todo el sitio .

Por ejemplo, puedes excluir fácilmente carpetas enteras o tipos de archivos.

<Files ~ “\/?no\-bake\/.*”> Header set X-Robots-Tag “noindex, nofollow”</Files>

Comprender las diferentes formas en que puedes influir en el rastreo y la indexación te ayudará a evitar los errores comunes que pueden evitar que se encuentren en tus páginas más importantes.

Clasificación

¿Cómo se aseguran los motores que cuando alguien escribe una consulta en la barra de búsqueda, obtiene resultados relevantes? ¿Es magia negra? No. Ese proceso se conoce como clasificación, o el orden de los resultados de búsqueda de más relevante a menos relevante para una consulta en particular.

Para determinar la relevancia, los motores de búsqueda utilizan algoritmos, un proceso o fórmula mediante el cual la información almacenada se recupera y ordena de manera significativa. Estos algoritmos han sufrido muchos cambios a lo largo de los años para mejorar la calidad de los resultados de búsqueda. Google, por ejemplo, realiza ajustes de algoritmo todos los días: algunas de estas actualizaciones son de menor calidad, mientras que otras son actualizaciones de algoritmos centrales / amplias e implementadas permanentemente para abordar un problema específico, como Penguin, incluido para evitar el spam en la construcción de enlaces.

¿Por qué el algoritmo cambia con tanta frecuencia? ¿Google solo está tratando de mantenernos alerta? Si bien Google no siempre revela detalles sobre por qué hacen lo que hacen, sí sabemos que el objetivo de Google al realizar ajustes en los algoritmos es mejorar la calidad general de la búsqueda. Por eso, en respuesta a las preguntas sobre la actualización del algoritmo, Google responderá con algo como: «Estamos haciendo actualizaciones de calidad todo el tiempo». Esto indica que, si tu sitio sufrió una bajada general después de un ajuste de algoritmo, compáralo con las Pautas de calidad de Google o las Pautas del evaluador de calidad de búsqueda , ambas son muy reveladoras en términos de lo que quieren los motores de búsqueda.

¿Qué persigue un motor de búsqueda?

Los motores de búsqueda siempre han querido lo mismo: proporcionar respuestas útiles a las preguntas de los buscadores en los formatos más útiles. Dando por hecho que esto sea cierto, ¿por qué parece que el SEO es diferente ahora que en años pasados?. En realidad se parece mucho al proceso de aprendizaje de un idioma.

Al principio, la comprensión del idioma es muy rudimentaria, pero con el tiempo, el conocimiento comienza a profundizarse y aprendemos semántica: el significado detrás del lenguaje y la relación entre palabras y frases. Eventualmente, con suficiente práctica, el estudiante conoce el idioma lo suficientemente bien como para comprender los matices y es capaz de dar respuestas incluso a preguntas vagas o incompletas.

Cuando los motores de búsqueda apenas comenzaban a aprender nuestro idioma, era mucho más fácil manipular el sistema usando trucos y tácticas que en realidad van en contra de las pautas de calidad. Tomemos como ejemplo el relleno de palabras clave. Si desea sclasificar para una palabra clave en particular como "coches en oferta", puedes agregar las palabras "coches en oferta" muchas veces en tu página y ponerla en negrita, con la esperanza de mejorar tu clasificación para ese término:

¡Bienvenidos a coches en oferta! ¡Tenemos los mejores coches en oferta! No encontrará en el mercado coches en oferta más baratos. Disfruta de nuestros coches en oferta...

Esto, en su momento, generó una muy mala experiencia para el usuario, que se veía bombardeado por texto sin sentido y que no aportaba absolutamente nada en relación con lo que estaba buscando.

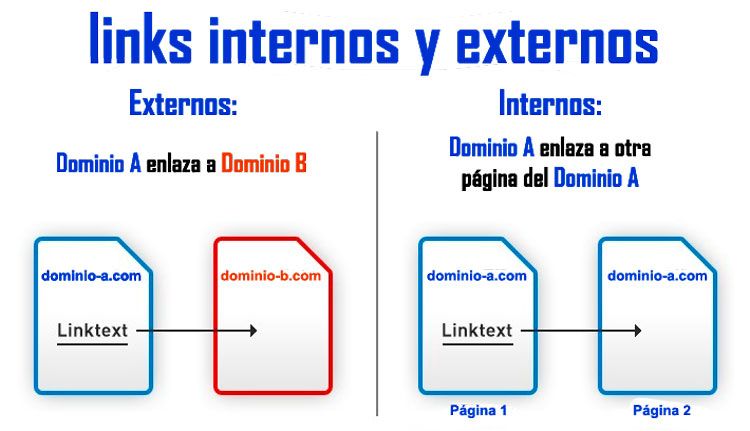

Los enlaces en el SEO

Cuando hablamos de enlaces, podríamos decir dos cosas. Los backlinks -vínculos de retroceso- o «enlaces entrantes» son enlaces de otros sitios web que apuntan a tu sitio web, mientras que los enlaces internos son enlaces en tu propio sitio que apuntan a tus otras páginas (en el mismo sitio).

Los enlaces han jugado históricamente un papel importante en el SEO. Desde el principio, los motores de búsqueda necesitaban ayuda para determinar qué URLs eran más confiables que otras para ayudarlos a determinar cómo clasificar los resultados de búsqueda. Calcular el número de enlaces que apuntan a un sitio determinado les ayudó a hacer esto.

Los vínculos de retroceso o backlinks funcionan de manera muy similar al «boca a boca» de la vida real. Tomemos como ejemplo una tienda de ropa, Macao Moda:

- Referencias de otros = buena señal de autoridad

- Ejemplo: muchas personas diferentes te han dicho que Macao Moda es la mejor de la ciudad.

- Referencias de ti mismo = parcial, por lo que no es una buena señal de autoridad

- Ejemplo: Macao afirma que Macao Moda es la mejor de la ciudad.

- Referencias de fuentes irrelevantes o de baja calidad = no es una buena señal de autoridad e incluso podría ser marcado como spam

- Ejemplo: Macao pagó para que personas que nunca habían visitado su tienda le dijeran a otros lo buena que es.

- Sin referencias = autoridad poco clara

- Ejemplo: Macao Moda puede ser bueno, pero no ha podido encontrar a nadie que tenga una opinión, por lo que no puede estar seguro.

Por eso se creó PageRank. PageRank (parte del algoritmo central de Google) es una fórmula de análisis de enlaces que lleva el nombre de uno de los fundadores de Google, Larry Page. PageRank estima la importancia de una página web midiendo la calidad y cantidad de enlaces que apuntan a ella. La suposición es que cuanto más relevante, importante y confiable es una página web, más enlaces habrá obtenido.

Cuantos más backlinks naturales tengas de sitios web de alta autoridad (confiables), mayores serán tus probabilidades de obtener una clasificación más alta en los resultados de búsqueda. Aquí no vale aquello de «que hablen mucho de uno, aunque sea mal».

El Contenido en el SEO

No tendrían sentido los enlaces si no dirigieran a los buscadores a algún sitio. Y ese sitio ha de tener algo bueno. El contenido es más que solo palabras; es cualquier cosa destinada a ser consumida por los buscadores: hay contenido de video, contenido de imagen y, por supuesto, texto. Si los motores de búsqueda son contestadores automáticas, el contenido es el medio por el cual los motores brindan esas respuestas.

Cada vez que alguien realiza una búsqueda, hay miles de resultados posibles, entonces, ¿cómo deciden los motores de búsqueda qué páginas va a encontrar valiosas para el buscador? Una gran parte de determinar dónde se clasificará tu página para una consulta determinada es qué bueno es el contenido de tu página en relación con la intención de la consulta. En otras palabras, ¿esta página coincide con las palabras que se buscaron y ayuda a completar la tarea que el buscador estaba tratando de lograr?

Debido a este enfoque en la satisfacción del usuario y el cumplimiento de la tarea, no hay puntos de referencia estrictos sobre la extensión que debe tener tu contenido, cuántas veces debe contener una palabra clave o qué debe poner en las etiquetas de su encabezado. Todos estos pueden influir en el rendimiento de una página en la búsqueda, pero la atención debe centrarse en los usuarios que leerán el lo que has publicado.

Hoy, con cientos o incluso miles de señales de clasificación, las tres principales se han mantenido bastante consistentes: enlaces a tu sitio web (que sirven como señales de credibilidad de terceros), contenido en la página (contenido de calidad que cumple con la intención de un buscador) y RankBrain.

¿Qué es RakBrain?

RankBrain es el componente de aprendizaje automático del algoritmo central de Google. El aprendizaje automático es un programa informático que continúa mejorando sus predicciones a lo largo del tiempo a través de nuevas observaciones y datos de entrenamiento. En otras palabras, siempre está aprendiendo y, como siempre está aprendiendo, los resultados de búsqueda deberían mejorar constantemente. Esta es la teoría.

Por ejemplo, si RankBrain nota una URL de clasificación más baja que proporciona un mejor resultado a los usuarios que las URL de clasificación más alta, puedes apostar a que RankBrain ajustará esos resultados, elevando el resultado más relevante y degradando las páginas menos relevantes como subproducto.

¿Qué significa esto para el SEO?

Debido a que Google continuará aprovechando RankBrain para promover el contenido más relevante y útil, debemos centrarnos en cumplir la intención del buscador más que nunca. Proporciona la mejor información y experiencia posibles para los buscadores que puedan aterrizar en tu página, y has dado un gran primer paso para tener una buena relación con ese ente virtual que es RankBrain.

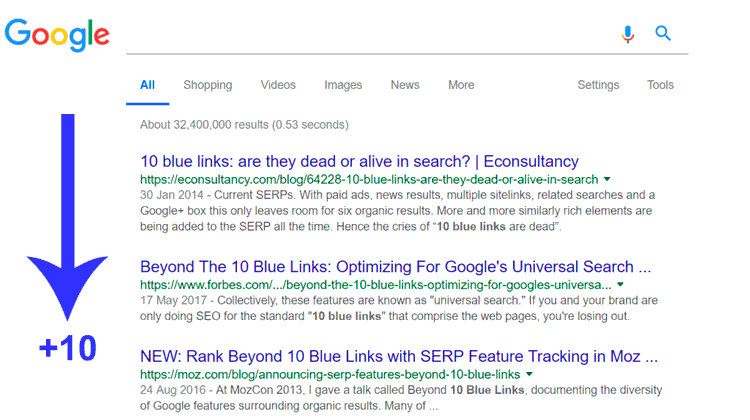

Evolución de los resultados de búsqueda

Cuando los motores de búsqueda carecían de la sofisticación que tienen hoy en día, se acuñó el término "10 enlaces azules" para describir la estructura plana de las SERPs. Cada vez que se realizaba una búsqueda, Google mostraba una página con 10 resultados orgánicos, cada uno en el mismo formato.

En este panorama de búsqueda, ocupar el puesto n.°1 era el santo grial del SEO. Pero entonces sucedió algo. Google comenzó a agregar resultados en nuevos formatos en sus páginas de resultados de búsqueda, llamadas funciones SERPs. Algunas de estas características de SERPs incluyen:

- Anuncios pagados

- Fragmentos destacados

- La gente también rellena cuestionarios

- Negocio local (mapa)

- Panel de conocimiento

- Vínculos a sitios

Y Google agrega nuevos constantemente. Incluso experimentaron con "SERPs de resultado cero", un fenómeno en el que solo se mostraba un resultado del Gráfico de conocimiento en las SERPs sin resultados debajo, excepto por una opción para "ver más resultados".

La adición de estas características provocó cierto pánico inicial por dos razones principales. Por un lado, muchas de estas características hicieron que los resultados orgánicos se redujeran aún más en las SERPs. Otra consecuencia es que menos buscadores hacen clic en los resultados orgánicos, ya que se responden más consultas en las propias SERPs.

Entonces, ¿por qué Google hacía esto? Todo se remonta a la experiencia de búsqueda. El comportamiento del usuario indica que algunas consultas se satisfacen mejor con diferentes formatos de contenido. Observe cómo los diferentes tipos de características SERPs coinciden con los diferentes tipos de intentos de consulta.

Veamos qué devuelve Google dependiendo del tipo de búsqueda:

- Informativo: Fragmento destacado.

- Informativo con una respuesta: Gráfico de conocimiento o respuesta instantánea.

- Local: Mapas.

- Transacciones: Compras.

Negocios Locales

Un motor de búsqueda como Google tiene su propio índice patentado de listados de empresas locales, a partir del cual crea resultados de búsqueda de negocios locales.

Si estás realizando un trabajo de SEO local para una empresa que tiene una ubicación física que los clientes pueden visitar (p. Ej., Dentista) o para una empresa que viaja para visitar a sus clientes (p. Ej., Plomero), asegúrate de reclamar, verificar y optimizar un Listado gratuito de Google My Business.

Cuando se trata de resultados de búsqueda localizados, Google utiliza tres factores principales para determinar la clasificación:

- Relevancia

- Distancia

- Si es Prominente

Relevancia

La relevancia es cuando una empresa local coincide perfectamente con lo que busca el rastreador. Para asegurarte de que la empresa está haciendo todo lo posible para ser relevante para los buscadores, haz todo lo posible para que la información de la empresa esté completa y sea precisa.

Distancia

Google utiliza tu ubicación geográfica para ofrecerte mejores resultados locales. Los resultados de la búsqueda local son extremadamente sensibles a la proximidad, que se refiere a la ubicación del buscador y/o la ubicación especificada en la consulta (si este incluyó una).

Los resultados de búsqueda orgánicos son sensibles a la ubicación de un buscador, aunque rara vez son tan extremos como en los resultados de negocios locales.

Prominente

Con la prominencia como factor, Google busca recompensar a las empresas que son conocidas en el mundo real. Además de la prominencia offline de una empresa, Google también busca algunos factores online para determinar la clasificación local, como:

- Reseñas: La cantidad de reseñas de Google que recibe una empresa local y el sentimiento de esas reseñas tienen un impacto notable en su capacidad para clasificar en los resultados locales.

- Citaciones: Una "cita comercial" o "ficha comercial" es una referencia basada en la web a un "NAP o NDT en castellano" de una empresa local (nombre, dirección, número de teléfono) en una plataforma localizada (Yelp, Acxiom, YP, Páginas Amarillas, etcétera.) Las clasificaciones locales están influenciadas por el número y la coherencia de las citas de empresas locales. Google extrae datos de una amplia variedad de fuentes para crear continuamente su índice de negocios locales. Cuando Google encuentra múltiples referencias consistentes al nombre, la ubicación y el número de teléfono de una empresa, fortalece la "confianza" del buscador en la validez de esos datos. Esto luego lleva a que Google pueda mostrar el negocio con un mayor grado de confianza. Google también utiliza información de otras fuentes en la web, como enlaces y artículos.

- Ránking Orgánico: Las mejores prácticas SEO también se aplican al SEO local, ya que Google también considera la posición de un sitio web en los resultados de búsqueda orgánicos al determinar la clasificación local.

Sin duda, ahora más que nunca, los resultados locales están siendo influenciados por datos del mundo real. Esta interactividad es la forma en que los buscadores funcionan y responden a las empresas locales, en lugar de información puramente estática como enlaces y citas.

Dado que Google desea ofrecer las mejores y más relevantes empresas locales a los buscadores, tiene mucho sentido que utilicen métricas de participación en tiempo real para determinar la calidad y la relevancia.