Inteligencia Artificial: ¿Emula de verdad la Inteligencia Humana?

La INTELIGENCIA ARTIFICIAL (IA) es el campo dentro de la informática que busca explicar y emular, a través de procesos mecánicos o computacionales, algunos o todos los aspectos de la inteligencia humana.

Entre estos aspectos de la inteligencia se incluyen la capacidad de interactuar con el entorno a través de medios sensoriales y la capacidad de tomar decisiones en circunstancias imprevistas sin intervención humana.

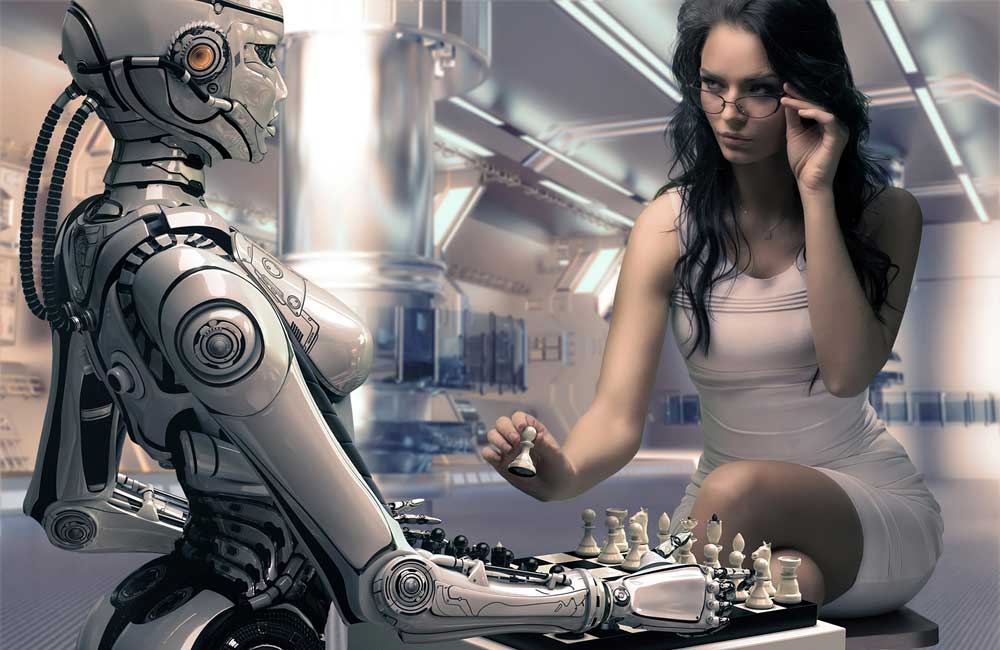

Las áreas típicas de investigación en IA incluyen la jugabilidad de juegos como las damas o el ajedrez, la comprensión y síntesis del lenguaje natural, la visión por computadora, la resolución de problemas, el aprendizaje automático y la robótica.

Lo anterior es una descripción general del campo; no hay una definición consensuada de la inteligencia artificial, principalmente porque no hay acuerdo sobre lo que constituye la inteligencia.

Las interpretaciones de lo que significa que un agente es inteligente varían, pero la mayoría se puede categorizar de una de tres maneras. La inteligencia se puede considerar como una cualidad, una propiedad individual separable de todas las demás propiedades de la persona humana.

La inteligencia también se ve en las funciones que realiza, en las acciones o la capacidad para llevar a cabo ciertas tareas. Finalmente, algunos investigadores ven la inteligencia como algo adquirido y demostrado principalmente a través de la relación con otros seres inteligentes. Cada uno de estos entendimientos de la inteligencia ha sido utilizado como base para desarrollar programas de computadora con características inteligentes.

Primeros Intentos: IA Simbólica

El campo de la IA se considera que tiene su origen en la publicación del artículo de Alan Turing "Computing Machinery and Intelligence" (1950). John McCarthy acuñó el término inteligencia artificial seis años después en una conferencia de verano en el Dartmouth College en New Hampshire.

El enfoque inicial en la IA se llama IA simbólica o clásica, que se basa en la hipótesis de que cada proceso en el que se involucra un ser humano o una máquina se puede expresar mediante una serie de símbolos que son modificables de acuerdo con un conjunto limitado de reglas que pueden definirse lógicamente.

Al igual que los geómetras comienzan con un conjunto finito de axiomas y objetos primitivos como puntos, los simbolistas, siguiendo a filósofos racionalistas como Ludwig Wittgenstein y Alfred North Whitehead, predijeron que el pensamiento humano se representa en la mente a través de conceptos que se pueden descomponer en reglas básicas y objetos primitivos.

Los conceptos o objetos simples se expresan directamente mediante un solo símbolo, mientras que las ideas más complejas son el producto de muchos símbolos, combinados por ciertas reglas. Para un simbolista, cualquier tipo de materia que se pueda patronear puede representar el pensamiento inteligente.

La IA simbólica tuvo éxito inmediato en áreas en las que los problemas podían describirse fácilmente utilizando un conjunto pequeño de objetos que operan en un dominio limitado de manera altamente basada en reglas, como los juegos.

El juego de ajedrez se desarrolla en un mundo donde los únicos objetos son treinta y dos piezas que se mueven en un tablero de sesenta y cuatro casillas de acuerdo con un número limitado de reglas.

Las opciones limitadas que este mundo proporciona le dan a la computadora el potencial para mirar hacia el futuro, examinando todas las posibles jugadas y contra jugadas, buscando una secuencia que deje sus piezas en la posición más ventajosa.

Otros éxitos de la IA simbólica ocurrieron rápidamente en dominios igualmente restringidos, como el diagnóstico médico, la prospección de minerales, el análisis químico y la demostración de teoremas matemáticos. Estos éxitos iniciales llevaron a muchas predicciones optimistas sobre las perspectivas de la IA simbólica.

Sin embargo, la IA simbólica fracasó no en problemas difíciles como aprobar un examen de cálculo, sino en las cosas fáciles que puede hacer un niño de dos años, como reconocer un rostro en diferentes entornos o comprender una historia simple.

McCarthy califica los programas simbólicos como frágiles porque se rompen o fallan en los bordes; no pueden funcionar fuera o cerca de los límites de su dominio de experiencia, ya que carecen de conocimiento fuera de ese dominio, conocimiento que la mayoría de los "expertos" humanos poseen en forma de lo que a menudo se llama sentido común.

Los humanos hacen uso de conocimientos generales, millones de cosas que sabemos y aplicamos a una situación, tanto de manera consciente como subconsciente. Si tal conjunto existe, ahora está claro para los investigadores de IA que el conjunto de hechos primitivos necesarios para representar el conocimiento humano es extremadamente grande.

Otra crítica a la IA simbólica, avanzada por Terry Winograd y Fernando Flores (Understanding Computers and Cognition, 1986), es que la inteligencia humana puede no ser un proceso de manipulación de símbolos; los humanos no llevan modelos mentales en sus cabezas.

Cuando un ser humano aprende a andar en bicicleta, no lo hace calculando ecuaciones de trayectoria o fuerza. Hubert Dreyfus plantea un argumento similar en Mind over Machine (1986); sugiere que los expertos no llegan a sus soluciones a través de la aplicación de reglas o la manipulación de símbolos, sino que usan la intuición, adquirida a través de múltiples experiencias en el mundo real.

Describe la IA simbólica como un "proyecto de investigación degenerativo", lo que significa que, aunque prometedor al principio, ha producido menos resultados a medida que ha avanzado el tiempo y es probable que se abandone si surgen otras alternativas. Su predicción ha demostrado ser bastante precisa.

Para el año 2000, el enfoque simbólico una vez dominante había sido prácticamente abandonado en la IA, con solo un proyecto importante en curso, el proyecto Cyc de Douglas Lenat. Lenat espera superar el problema del conocimiento general al proporcionar una base extremadamente grande de hechos primitivos.

Lenat planea combinar esta gran base de datos con la capacidad de comunicarse en un lenguaje natural, con la esperanza de que una vez que se ingrese suficiente información en Cyc, la computadora podrá continuar el proceso de aprendizaje por sí sola, a través de la conversación, la lectura y la aplicación de reglas lógicas para detectar patrones o inconsistencias en los datos que se le proporcionan. Concebido inicialmente en 1984 como una iniciativa de diez años, Cyc aún no ha demostrado pruebas convincentes de un aprendizaje independiente extendido.

Sin embargo, la IA simbólica no está completamente muerta. La primacía de los objetos primitivos representables por algún sistema de codificación es una suposición básica que subyace en la concepción de que todo se puede entender en términos de información, una visión que ha sido promovida por varios físicos, incluidos Freeman Dyson, Frank Tipler y Stephen Wolfram.

IA Funcional o Débil

En 1980, John Searle, en el artículo "Mentes, cerebros y programas", introdujo una división del campo de la IA en "fuerte" y "débil". La IA fuerte denota el intento de desarrollar una inteligencia completamente similar a la humana, mientras que la IA débil denota el uso de técnicas de IA para entender mejor el razonamiento humano o resolver problemas más limitados.

Aunque hubo poco progreso en el desarrollo de una IA fuerte a través de métodos de programación simbólica, el intento de programar computadoras para llevar a cabo funciones humanas limitadas ha tenido bastante éxito.

Gran parte de lo que actualmente se denomina investigación de IA sigue un modelo funcional, aplicando técnicas de programación específicas, como la ingeniería del conocimiento, la lógica difusa, los algoritmos genéticos, las redes neuronales, la búsqueda heurística y el aprendizaje automático a través de métodos estadísticos, a problemas prácticos.

Esta visión ve la IA como una forma avanzada de computación. Produce programas que pueden asumir ciertas tareas humanas, especialmente en situaciones en las que hay un control humano limitado o donde el conocimiento necesario para resolver un problema no puede ser completamente anticipado por los programadores humanos. Estos programas se utilizan en operaciones de fabricación, transporte, educación, mercados financieros, edificios "inteligentes" e incluso electrodomésticos.

Para una IA funcional, no es necesario que exista una calidad denominada "inteligencia" que se comparta entre los humanos y las computadoras. Todo lo que las computadoras necesitan hacer es realizar una tarea que requiera inteligencia para que un ser humano la realice.

Tampoco es necesario, en la IA funcional, modelar un programa según los procesos de pensamiento que usan los humanos. Si lo que importa son los resultados, es posible explotar la velocidad y las capacidades de almacenamiento de la computadora digital, mientras se ignoran partes del pensamiento humano que no se entienden o que no se pueden modelar fácilmente, como la intuición.

Esto es, de hecho, lo que se hizo en el diseño del programa de ajedrez Deep Blue, que venció al campeón mundial reinante, Garry Kasparov, en 1997. Deep Blue no intenta imitar el pensamiento de un jugador de ajedrez humano. En cambio, capitaliza las fortalezas de la computadora examinando un número extremadamente grande de movimientos, más de los que cualquier ser humano podría examinar.

Hay dos problemas con la IA funcional. El primero es la dificultad de determinar qué cae en la categoría de IA y qué es simplemente una aplicación de computadora normal.

Una definición de IA que incluya cualquier programa que realice alguna función normalmente realizada por un ser humano abarcaría prácticamente todos los programas de computadora. Incluso entre los científicos de la computación, hay poco acuerdo sobre qué tipos de programas caen bajo la rúbrica de la IA. Una vez que una aplicación se domina, tiende a dejar de definirse como IA.

Por ejemplo, aunque el juego es uno de los campos clásicos de la IA, el equipo de diseño de Deep Blue afirmó enfáticamente que Deep Blue no era inteligencia artificial, ya que utilizaba programación estándar y técnicas de procesamiento paralelo que de ninguna manera estaban diseñadas para imitar el pensamiento humano.

La implicación aquí es que simplemente programar una computadora para realizar una tarea humana no es IA si la computadora no realiza la tarea de la misma manera que lo haría un ser humano.

Para que un enfoque funcional resulte en una inteligencia plenamente similar a la humana, sería necesario no solo especificar qué funciones componen la inteligencia, sino también asegurarse de que esas funciones sean adecuadas entre sí. Los programas de IA funcional rara vez están diseñados para ser compatibles con otros programas; cada uno utiliza diferentes técnicas y métodos, cuya suma es poco probable que capture la totalidad de la inteligencia humana.

Muchos en la comunidad de la IA también están insatisfechos con una colección de programas orientados a tareas. La construcción de una inteligencia general similar a la humana, por difícil que pueda parecer, sigue siendo la visión.

Un Enfoque Relacional

Un tercer enfoque en la IA se basa en la suposición de que la inteligencia se adquiere, se mantiene y se demuestra solo a través de relaciones con otros agentes inteligentes. En "Computing Machinery and Intelligence", Turing aborda la pregunta de cuáles funciones son esenciales para la inteligencia con una propuesta que ha llegado a ser el examen generalmente aceptado de la inteligencia de una máquina.

Un interrogador humano está conectado por terminal a dos sujetos, uno humano y otro una máquina. Si el interrogador falla tan a menudo como tiene éxito en determinar cuál es el humano y cuál es la máquina, se podría considerar que la máquina es inteligente.

La Prueba de Turing se basa no en la realización de una tarea específica o en la solución de problemas particulares por parte de la máquina, sino en la capacidad de la máquina para relacionarse con un ser humano en una conversación.

El discurso es único entre las actividades humanas en que subsume todas las demás actividades dentro de sí mismo. Turing predijo que para el año 2000 habría computadoras que podrían engañar a un interrogador al menos el 30 por ciento del tiempo. Esto, al igual que la mayoría de las predicciones en la IA, fue excesivamente optimista. Ninguna computadora ha llegado a pasar la Prueba de Turing.

La Prueba de Turing utiliza el discurso relacional para demostrar la inteligencia. Sin embargo, Turing también destaca la importancia de estar en relación para la adquisición de conocimiento o inteligencia. Estima que la programación de conocimientos básicos necesaria para una forma restringida del juego llevaría, como mínimo, trescientos años-persona para completarse.

Prueba de Turing IA

Prueba de Turing IA

Esto supone que uno podría identificar el conjunto de conocimientos apropiado desde el principio. Turing sugiere, en lugar de tratar de imitar una mente adulta, que se construya una mente que simule la de un niño. Esta mente, cuando recibe una educación adecuada, aprendería y se desarrollaría en una mente adulta.

Un investigador de IA que sigue este enfoque es Rodney Brooks del Instituto de Tecnología de Massachusetts (MIT), cuyo laboratorio de robótica ha construido varias máquinas, las más famosas de las cuales se llaman Cog y Kismet, que representan una nueva dirección en la IA en la que la corporeidad es fundamental para su diseño.

Su programación se distribuye entre las distintas partes físicas; cada articulación tiene un pequeño procesador que controla el movimiento de esa articulación. Estos procesadores están vinculados con procesadores más rápidos que permiten la interacción entre las articulaciones y el movimiento del robot en su conjunto.

Cog y Kismet ya no son mentes en una caja, sino sistemas encarnados que dependen de la interacción dentro de un entorno complejo. Están diseñados para aprender tareas asociadas a los recién nacidos, como la coordinación ojo-mano, la sujeción de objetos, el reconocimiento facial y respuestas emocionales básicas, a través de la interacción social con un equipo de investigadores.

Aunque han desarrollado habilidades como el seguimiento de objetos en movimiento con los ojos o retirar un brazo cuando son tocados, el proyecto de Brooks no ha tenido más éxito hasta ahora que el proyecto de Lenat's Cyc en la producción de una máquina que pueda interactuar con los humanos al nivel de la Prueba de Turing. Sin embargo, el trabajo de Brooks representa un movimiento hacia la opinión de Turing de que la inteligencia se adquiere y se demuestra de forma social.

La Prueba de Turing no hace suposiciones sobre cómo la computadora llegaría a sus respuestas; no es necesario que haya una similitud en el funcionamiento interno entre la computadora y el cerebro humano.

Sin embargo, un área de la IA que muestra cierta promesa es la de las redes neuronales, sistemas de circuitos que reproducen los patrones de neuronas que se encuentran en el cerebro.

Redes Neuronales IA

Redes Neuronales IA

Sin embargo, las redes neuronales actuales tienen limitaciones. El cerebro humano tiene miles de millones de neuronas y los investigadores aún no comprenden cómo están conectadas estas neuronas y cómo funcionan los diversos productos químicos neurotransmisores en el cerebro.

A pesar de estas limitaciones, las redes neuronales han reproducido comportamientos interesantes en áreas como el reconocimiento de voz o imágenes, el procesamiento del lenguaje natural y el aprendizaje.

Algunos investigadores (por ejemplo, Hans Moravec, Raymond Kurzweil) ven la investigación de redes neuronales como una forma de ingeniería inversa del cerebro.

Esperan que una vez que los científicos tengan la capacidad de diseñar redes con una complejidad igual a la del cerebro, descubrirán que las redes tienen el mismo poder que el cerebro y desarrollarán la conciencia como una propiedad emergente.

Kurzweil postula que tales cerebros mecánicos, cuando se programan con las memorias y talentos de una persona dada, podrían representar un nuevo camino hacia la inmortalidad, mientras que Moravec sostiene la esperanza de que tales máquinas algún día puedan convertirse en nuestros hijos evolutivos, capaces de habilidades mayores que las que los humanos demuestran actualmente.

IA en la Ciencia Ficción

A pesar de algunos avances, una computadora verdaderamente inteligente todavía se encuentra en el ámbito de la especulación. Aunque los investigadores han proyectado constantemente que las computadoras inteligentes están próximas, el progreso en la IA ha sido limitado.

Computadoras con intencionalidad y autoconciencia, con habilidades de razonamiento plenamente humanas o la capacidad de establecer relaciones, existen solo en el reino de los sueños y deseos, un reino explorado en la ficción y la fantasía.

La computadora artificialmente inteligente en la historia y el cine de ciencia ficción no es un accesorio, sino un personaje, que se ha convertido en un elemento básico desde mediados de la década de 1950.

Estos personajes se encarnan en una variedad de formas físicas, que van desde lo completamente mecánico (computadoras y robots) hasta lo parcialmente mecánico (cíborgs) y lo completamente biológico (androides).

Una tendencia general desde la década de 1950 hasta la de 1990 ha sido representar a las computadoras inteligentes de una manera cada vez más antropomórfica. Los robots y las computadoras de películas tempranas, como Maria en "Metropolis" (1926), Robby en "Forbidden Planet" (1956), Hal en "2001: Odisea del espacio" (1968), o R2D2 y C3PO en "Star Wars" (1977), eran claramente construcciones de metal.

Por otro lado, las primeras historias de ciencia ficción, como "Yo, Robot" de Isaac Asimov (1950), exploraban la cuestión de cómo distinguir entre robots que parecían humanos y seres humanos reales. Películas e historias desde la década de 1980, como "Blade Runner" (1982), la serie "Terminator" (1984-2002) y "A.I.: Inteligencia artificial" (2001), representan máquinas con partes mecánicas y biológicas que son, al menos superficialmente, prácticamente indistinguibles de los seres humanos.

La ficción que presenta la IA se puede clasificar en dos categorías generales. La primera comprende relatos de advertencia que exploran las consecuencias de crear tecnología con el propósito de tomar el control de las funciones humanas.

En estas historias, los impulsos iniciales para crear una inteligencia artificial son nobles: preservar la sabiduría de una raza (Forbidden Planet), evitar la guerra nuclear (Colossus: The Forbin Project, 1970) o avanzar en el conocimiento humano (2001: Odisea del espacio).

Los personajes humanos suponen que tienen el control total, solo para descubrir que han cedido demasiada responsabilidad a algo que es en última instancia "otro" para la especie humana.

La segunda categoría comprende relatos de realización de deseos (Star Wars; Yo, Robot), en los que los robots no se destacan por su inteligencia o por su capacidad de razonar, sino por sus cualidades emocionales y por la esperanza de que algún día puedan sentirse completamente humanos.

Las inteligencias artificiales que son mucho más inteligentes que los humanos o capaces de construir inteligencias aún más avanzadas tienden a ser retratadas como inhumanas o destructivas (Blade Runner). Cualquier cosa con inteligencia y conciencia que sea capaz de diseñar inteligencias aún más avanzadas es una amenaza.

Películas como "The Matrix" (1999) o "Ex Machina" (2014) han planteado cuestiones profundas sobre la naturaleza de la realidad, la conciencia y la relación entre humanos y máquinas inteligentes.

A menudo, estas historias exploran la idea de que las máquinas pueden superar a los humanos, ya sea como resultado de la rebelión o de la evolución. La creación de sistemas informáticos que adquieren independencia y autonomía plantea preocupaciones sobre el futuro de la humanidad. ¿Cuál sería el papel de los humanos si las máquinas se vuelven más inteligentes y capaces? ¿Las máquinas actuarán en beneficio de la humanidad o tomarán el control? Estas son cuestiones éticas y filosóficas profundas que las obras de ciencia ficción han explorado.

En resumen, la inteligencia artificial es un campo que ha evolucionado desde su concepción original como un intento de emular la inteligencia humana con programas de computadora.

Ha habido enfoques simbólicos que se basan en reglas lógicas y representaciones simbólicas, pero que tienen dificultades para capturar el conocimiento humano completo y la intuición. También ha habido enfoques funcionales, que se centran en la construcción de sistemas que realizan tareas específicas de manera efectiva, pero que no intentan emular la inteligencia humana en su totalidad.

Además, existe un enfoque relacional que se basa en la interacción y la adquisición de conocimientos a través de la relación con otros agentes inteligentes, como se plantea en la Prueba de Turing y se explora en sistemas basados en redes neuronales.

Si bien la IA ha hecho avances significativos en áreas como el procesamiento del lenguaje natural, el reconocimiento de patrones y la automatización de tareas, aún no ha logrado crear una inteligencia completamente similar a la humana. El campo de la IA sigue siendo un tema de investigación en constante evolución y debate, con desafíos y promesas en áreas que abarcan desde la tecnología hasta la ética y la filosofía.

NOTA: Imágenes de Depositphotos.com